Zur Feier des ersten Jahrestages der PQC-Standards – 13.8.2024

und als kleine Hommage an die diesjährigen Nobelpreisträger in Physik John Clarke, Michel H. Devoret und John M. Martinis.

«Dass ich erkenne, was die Welt

Im Innersten zusammenhält,

Schau‘ alle Wirkenskraft und Samen,

Und tu‘ nicht mehr in Worten kramen.»

Wenn der alte Goethe gewusst hätte, wie tief die Menschen in die Welt des Kleinsten eingedrungen sind und worüber wir uns heute den Kopf zerbrechen… Doch bevor wir der imaginären Katze von Erwin Schrödinger etwas Futter geben, sei kurz angemerkt, dass dies vor ca. 100 Jahren, es fehlen wohl noch ein paar Tage, an der Universität Zürich mit dem vom ihm geprägten Begriff der Superposition im November 1925 richtig Fahrt aufnahm. Wer geschichtlich dazu abtauchen möchte, dem sei dieser Artikel empfohlen.

Nachdem Max Planck uns die Quantelung der Energie aufgezeigt hatte und all die grossen Physiker (Niels Bohr, Werner Heisenberg, Erwin Schrödinger, Pascual Jordan, Max Born, Wolfgang Pauli, Paul Dirac, …) des 20. Jahrhunderts, die diese Idee weiterentwickelten, hinzugekommen waren, kamen Paul Benioff und vor allem Richard Feynman in den Jahren 1981/1982 auf die Idee, dass man damit rechnen könnte.

Und um das «nicht mehr in Worten kramen» zu unterstreichen, hier noch ein Zitat von Nathaniel David Mermin zur Kopenhagener Deutung von Bohr und Heisenberg.

Da wir mit unseren Vorstellungen und unserer Sprache seit tausenden von Jahren vor allem makroskopische Sachverhalte beschreiben und in diesen denken, sollten wir nicht versuchen, die Vorgänge der Quantenphysik und Quantenmechanik mit unserer Sprache und Vorstellungen übereinzubringen, sondern die Sprache der Mathematik zu verwenden.

Wenn Richard Feynman behauptet, dass man Quanten-Computer (QC) bauen kann, dann will man das auch umsetzen. Wer hier abtauchen will, der kann das auf quantencomputer-Info.de tun.

Schon 1994 kommt Peter Shor mit seinen theoretischen Algorithmen, die zeigen, wie man das Problem der Faktorisierung grosser Zahlen und auch das diskrete Logarithmusproblem mit Quantencomputern lösen kann. Also eigentlich zwei Algorithmen von Peter. Ja genau, das zielt direkt auf RSA ab und der andere auf DH und ECC.

Als Lov Grover dann 1996 noch die Suche nach der Nadel im Heuhaufen massiv beschleunigt (!) und damit eine Brute-Force-Attack für AES findet, was es damals noch gar nicht gab, stand die gesamte heutige Kryptografie im Fokus der Erneuerung. Aus 2128 werden quasi √2128=264. Da dies als zu unsicher angesehen wurde, gibt es AES-256. Einfach die Anzahl der möglichen Schlüssel 128-mal verdoppeln, und schon haben wir selbst bei zukünftigen starken QCs Zeit gewonnen.

Sicher definieren wir in der Kryptografie dadurch, dass der Aufwand (time, money) grösser sein muss, als der Wert der Information, damit sich das «Geschäft» für den Angreifer nicht lohnt.

Warum geht das nun schneller?

Quantencomputer können nur spezielle Aufgaben schnell abarbeiten, aber diese dann um Welten effizienter. Und es ist nicht einfach die Darstellung von vielen Zahlen gleichzeitig, Inputregister und Outputregister in einem, sondern man braucht auch Quantengates zur Manipulation… Aber das mit den Qubits ist anschaulicher und sollte nicht mit der Menge an Bits verwechselt werden, die benötigt werden, um mit binären Computer Quantencomputer zu simulieren.

Qubits

Hier könnten wir noch einmal Schrödingers Gedankenexperiment mit der Katze heranziehen, aber die Superposition, die Überlagerung der Zustände, führt dazu, dass wir mit einem Qubit, stark vereinfacht, 0 und 1 gleichzeitig darstellen können. Mit zwei Qubits 00 – 01 – 10 – 11 gleich 4 Zahlen und mit acht Qubits 256 Zahlen – 0 bis 255. Dazu brauchen wir 256 byte auf unseren binären Maschinen. Bei 47 Qubits wird es spannend, dann sind es 16 TB, langsam wird es im RAM eng… Das ist kein handelsüblicher Rechner mehr. Mit jedem Qubit verdoppeln wir die Menge. Mit 64 Qubits kommen wir an die Grenze der Adressierbarkeit der Speicherkapazitäten und erinnern uns an die Geschichte mit dem Reiskorn auf dem Schachbrett.1

Die genaue Darstellung eines N-Quantenregisters als 2ⁿ-dimensionaler Vektor in einem Hilbertraum mit komplexen Koeffizienten lassen wir hier einmal weg.

Aber zwei Bilder, das Kartenspiel und das Labyrinth, sind in dem Kontext noch ganz hübsch, auch wenn jeder Vergleich hinkt und wir schon gelernt haben, dass wir stur rechnen sollen.

Wenn in einem Kartenspiel nach einer bestimmten Karte gesucht wird, dann nimmt ein klassischer Computer eine Karte auf, «schaut» sie an und legt sie wieder zurück, wenn es noch nicht die Richtige war. Ein QC kann alle Karten auf einmal aufnehmen und sucht gleichzeitig in allen.

Oder das Labyrinth. Wenn es in einem solchen mehrere Wege heraus gibt, dann muss ein klassischer Rechner alle Wege nacheinander ausprobieren. Ein QC kann alle Wege gleichzeitig prüfen, wie er das auch beim Problem des Handlungsreisenden tut.

IBM hatte im Dezember 2023 mit IBM Condor einen 1121 Qubit Chip vorgestellt.

Aktuell scheint die Entwicklung vor allem durch error correction und die Anzahl der Gates getrieben. Und es gibt auch nicht den einen Quantencomputer. Photonenbasierte, ionenbasierte, supraleitende, Elektronenspin in Quantenpunkten, Strickstoff-Fehlstellen-Zentren sind verschiedene Entwicklungen und es wird viel Geld investiert.

PQC

Nun zum eigentlichen Thema. Post Quantum Cryptography oder Quanten-Computer resistente Kryptografie hat wenig mit Quantenkryptografie zu tun. Das ist ein ganz anderes Feld – vielleicht ein Quantenfeld aus den Quantenfeldtheorien (elektro, chromo, flavour)? Just joking.

Die Tür zur Post Quantum Cryptography wurde schon Ende der siebziger Jahre (McEliece 1978) des letzten Jahrhunderts aufgestossen, und seitdem ist auch viel passiert. Der Aufwand für Speicher und CPU-Ressourcen, der gebraucht wird, ist aber ungleich grösser als bei DH, RSA und ECC, weshalb man bis heute auf diese setzt. Auch die Mathematik, die dabei eine Rolle spielt, ist etwas komplizierter. Wer das mag, dem empfehle ich die Neuauflage von «Kryptografie verständlich», aktuell nur in englisch «Understanding Cryptography second edition» von Paar, Pelzl und Güneysu mit einem Vorwort von Ron Rivest – das R in RSA verfügbar. Ich kann auch immer noch die Vorlesungen von Christof Paar auf YouTube empfehlen. Neu auch zum Thema PQC. Lecture 23 & 24

Seit dem 13. August 2024 sind die Algorithmen von der NIST festgelegt, standardisiert und publiziert. Ja es gibt auch 2025 noch Nachzügler mit HQC oder auch noch in den nächsten Jahren. Die Hersteller können sich nun auf diese Standards fokussieren.

Die Signature-Verfahren LMS und XMSS lasse ich mal bewusst aussen vor, um den Rahmen nicht ganz zu sprengen.

| Official name | IPS number | Function | Based on |

|---|---|---|---|

| ML-KEM Module Lattice-Based Key encapsulation Mechanism / key exchange | FIPS203 08-13-2024 | Encryption | Kyber CRYSTALS (Cryptographic Suite for Algebraic Lattices) |

| ML-DSA Module-Lattice-Based Digital Signature Algorithm | FIPS204 08-13-2024 | Signature | CRYSTALS-Dilithium |

| SLH-DSA Stateless hash-based Digital Signature Algorithm | FIPS205 08-13-2024 | Alternate to FIPS204 | Sphincs+ |

| FN-DSA Lattice-based | FIPS206 Draft 8/2025 | Signature | Falcon NTRU (n-th degree‐truncated polynomial ring units) |

| HQC code-based Key encapsulation / key exchange | Expected in 2026/27 | Alternate to FIPS203 | Hamming Quasi-Cyclic |

Es wird mit diesen Algorithmen wichtiger, genau zu unterscheiden, ob es sich um Digital Envelopes (kem, key agreement) oder um Digital Signing handelt, da diese nicht mehr so universell einsetzbar sind, wie wir es von RSA und ECC gewohnt waren.

To do

Was machen wir denn nun?

- Für mich ist das Verstehen wichtig und grundlegend

- Dann muss man schauen, was man hat und was es zu ändern gilt

- Dann handeln

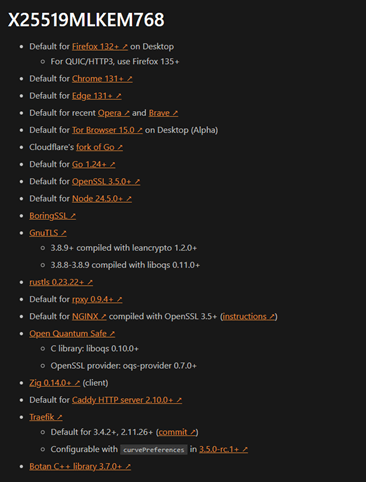

Die ersten Implementierungen finden sich in den kryptografischen Bibliotheken der Betriebssysteme und der Applikationen. Gerade für Browser und WebServer gibt es schon länger Testimplementierungen, die nun auf die offiziellen Standards umgestellt werden. Die Festlegung und Spezifizierung der Protokolle ist dabei noch on-going.

Die Browser sind eigentlich parat und unterstützen den hybriden Ansatz.

Im OpenSSL gibt es schon seit Jahren Implementierungen der Vorläufer Kyber, Dilithium, Falcon, … die nun auf die Standards umgestellt wurden und werden.

Auch Microsoft hat massiv die CryptoAPI aufgebohrt, ist vorbereitet und es kommt in die Produkte.

Digital Signing

- Code signing

- Document signing

- E-Mail siging

- Zertifikate

- Authentisierungen

Die Frage ist hier, bis wann müssen die Signaturen als sicher verifiziert werden können, so dass wir sicher sein können, dass Software oder Dokumente/E-Mail nicht manipuliert wurden und der Ersteller eindeutig identifiziert werden kann.

Code signing

Bei Software für Maschinen und Geräte-Steuerung muss man sich das wohl schon heute überlegen, wenn die Signatur erstellt wird, damit wir 2035 uns noch darauf verlassen können. Das wäre knapp 10 Jahre. Gerade bei Maschinen, Autos, Flugzeugen oder auch bei medizinischen Geräten haben wir in den letzten Jahren genügend Erfahrungen sammeln können, das Updates Zeit brauchen.

Document signing

Für Rechnungen ist das wohl an die Aufbewahrungsfristen gekoppelt. Rechnungen muss man 10 Jahre nachvollziehen können, Architekturpläne sollten vielleicht auch länger verlässlich sein. Wenn eine Brücke für 70 Jahre ausgelegt ist und in 30 Jahren bestimmte Prüfungen notwendig sind, dann … . Signiert man die Pläne dann zum Q-Day neu? Man möchte sich das und erst recht nicht in der Medizin vorstellen. Wie lange hat man einen Schrittmacher?

Certificates

Zertifikate selbst sind auch signiert und gerade bei Zertifikaten der Zertifizierungsstellen, die viele Jahre gültig sind, muss man langsam die Frage stellen, wie lange wir uns auf die etablierten Signaturen verlassen können. Jedenfalls macht es wohl wenig Sinn, diese noch für mehr als 10 Jahre auszustellen.

Dann betrachte man die Aussage “One 2024 study estimates that approximately 1730 logical qubits (error-corrected qubits) and on the order of 236 quantum gate operations could factor a 2048-bit RSA modulus in a single run“ und die Pläne / Roadmap von IBM “This is followed by Blue Jay, a system capable of executing 1 billion gates across 2,000 qubits by 2033. ” Das sind dann mehr als die 236 Gatter.

236 = 68.719.476.736

Authentisierungen

Das ist ein spezielles «digital signature»-Thema. Mit den Signaturen weisen wir nach, wer wir sind – non-repudiation – Nicht-Abstreitbarkeit. Auch Server werden so identifiziert. Heute verwenden wir hauptsächlich RSA in den Zertifikaten. Im mobilen Umfeld eher ECC. In den Lösungen für die Administration werden on-demand Zertifikate erstellt und auch FIDO2 und Passkey basieren auf ECC – just public private key. Das ist nicht so zeitkritisch wie code oder document signing. In einem kleineren Unternehmen kann man alle Smart Cards innerhalb von wenigen Wochen oder Monaten umstellen, aber in grösseren Firmen oder gar in Behörden braucht es dazu Jahre der Vorbereitung, Planung und ist eine enorme logistische Herausforderung.

Digital Envelope

Hier fallen alle Verfahren darunter, bei denen der Inhalt auch geheim bleiben soll. Das «Harvest Now, Decrypt Later» ist eine Strategie, die vor allem bei den berühmt berüchtigten Sicherheitsdiensten eine Rolle spielen, aber generell auch für Banken oder allen Unternehmen, die Daten übertragen, die noch in Jahren kritischen sein können. Das hatte Ed Snowden ja recht deutlich gemacht. Ob da die WhatsApp-Daten, hier wird ECC verwendet, interessant sind? Lasse ich mal als rhetorische Frage rumstehen.

Für TLS gibt es heute schon den hybriden Ansatz, und die Alternativen für pure PQC werden in den kommenden neuen Protokollen definiert.

Die Umsetzung erfolgt nach oft und viel dokumentierten Plänen.

https://pqcc.org/wp-content/uploads/2025/05/PQC-Migration-Roadmap-PQCC-2.pdf

Die Crypto-Agilität gewährleistet einen -fachen Umstieg der Algorithmen und ist grundsätzlich heute auch gegeben, aber wir müssen es verifizieren, die Prozesse verstehen und testen. Ein Key-Management hilft dabei, auch die Vertraulichkeit der Daten langfristig zu gewährleisten. Es gibt verschiedene Anleitung wie man zum Ziel kommt, hier eine Variante an der man sich orientieren kann.

A Roadmap to agile cryptographic security

1. Discovery and Prioritization

-

- Bewertung der Bedrohungslage

- Bewertung von Zufallsquellen

- Bestandsaufnahme der Vermögenswerte und Risikobewertung

- Überlegungen zum Lebenszyklus

→ Da können wir heute ran und loslegen

2. Incremental Implementation

-

- Vorbereitung und Testen

- Sukzessive Bereitstellung

- Kontinuierliche Überwachung und Verbesserung

→ Step-by-step, aber das kann man auch schon teilweise ran

3. Leverage Alliance Expertise for a Seamless Transition

-

- Implementieren der PQC

- Sichere Verwaltung und Schutz von Daten während ihres gesamten Lebenszyklus

- Aufrechterhaltung der Betriebskontinuität bei gleichzeitiger Bekämpfung neuer Bedrohungen

→ Hier haben wir eher noch Zeit, aber schaut nach einem Plan aus

Q-Day und CRQC (Cryptographically Relevant Quantum Computers)

Ob wir nun schon zu spät (q-day-crqc-predictions) dran sind, wird sich erst dann zeigen, wenn in den nächsten zehn Jahren Software und Dokumente manipuliert werden. Ob wir jemals feststellen, ob ein Geheimdienst Informationen aus einem Datastream exfiltriert, den er Jahre zuvor aufgezeichnet hat? Betriebssystem und Software werden heute in bestimmten auch sensitiven Bereichen mehr als 20 Jahre verwendet. Windows XP lässt grüssen. Deshalb kann man schon behaupten der Q-Day war schon.

Dieser Tag, wenn also QC in der Lage sind RSA, DH und ECC zu knacken, irgendwann wird es auch AES-256 treffen, aber erst das eine dann der nächste Schritt, dann müssen wir uns die Frage stellen, waren wir vorbereitet?

Müssen Dokumente, Software nun neu signiert werden, Smart Cards ausgetauscht werden, wer hat in der letzten Zeit unsere verschlüsselte Kommunikation aufgezeichnet und macht sich nun ans Werk? Das ist sicherlich nicht der richtige Weg.

Das obige Beispiel mit dem IBM Blue Jay zeigt, wir müssen von 2033 rückwärtsrechnen und uns selbst eingestehen, dass Signaturen aus dem Jahre 2023 wohl keine 10 Jahre mehr halten. Ob dann noch aufgezeichneten Daten relevant sind hängt vom Inhalt ab.

Die Herausforderungen, mit denen wir sicherlich in den nächsten Jahren zu kämpfen haben, sind ein Bewusstsein für die Probleme der Zukunft zu schaffen, da wir sie heute angehen müssen. Es gibt sicherlich auch heute schon genügend Herausforderungen, aber wenn wir die Themen nicht angehen, dann gehört das später zum SoY – Shit of Yesterday.

Die Mythen und die Missverständnisse der Q-Day liegt weit in der Zukunft und QC werden in den nächsten paar Jahren noch keine Algorithmen knacken, sollte uns gerade motivieren jetzt die Lücke zu schliessen. Please mind the gap! Ja hoffentlich ist die Entwicklung nicht so schnell, aber wir müssen uns darauf einstellen, denn meist geht es dann in der IT doch schneller als gedacht. Die Kryptografie (Algorithmen, Protokolle, Applikation) sollte Jahre vor dem Q-Day geändert sein, damit «Harvest Now and Decrypt Later» kein Risiko für das Unternehmen oder die Organisation wird, denn wenn QC in der Lage sind die heutigen Algorithmen zu knacken, ist es zu spät. Dann sollten die code und document signings safe und die aufgezeichneten data streams nicht mehr kritische Daten enthalten.

Und auch der gap an Ressourcen oder schöner – das Spannungsfeld zwischen den finanziellen Möglichkeiten, der zur Verfügung stehende Zeit und dem Verstehen der eigenen Prozesse, Infrastruktur, dem notwendigen Know-How-Aufbau – macht es nicht leichter.

Fazit

Ich bin noch weit davon entfernt, es zu verstehen, und kratze sicher nur an der Oberfläche – aber ich kratze.

Nur wenn wir das Thema angehen, uns vielleicht sogar etwas Mathematik antun, diskutieren, im positiven Sinne streiten und auch testen – also Erfahrungen sammeln –, werden wir auch in Zukunft vertrauenswürdige Dokumente, Software, Kommunikation und Authentisierung geniessen können.

mephisto

mephisto ist Security-Spezialist und langjähriger Mitarbeiter bei AVANTEC. Am liebsten beschäftigt er sich mit Authentication, Encryption und echtem Schutz gegen Malware. mephisto streitet sich gern, um die Lösungen richtig zu verstehen, denn: "Ich bin ein Teil von jener Kraft, die stets das Böse will und stets das Gute schafft."