Würde man mich fragen, so ist ChatGPT aktuell wohl die bekannteste KI. Es wurde ja schon sehr viel geschrieben und publiziert zu ChatGPT – die neue Revolution in der Geschäftswelt und viele werden ihre Jobs verlieren. Doch was für Security-Risiken erzeugt die Nutzung von ChatGPT? Dies will ich in diesem Blogartikel genauer beleuchten.

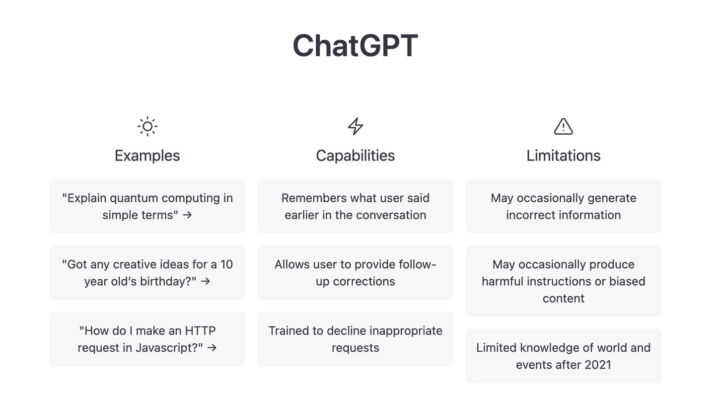

ChatGPT ist ja nicht wirklich sehr intelligent, nicht mal eine «echte» KI, sondern eher ein Sprachmodell, das darauf spezialisiert ist, menschenähnliche Konversationen zu führen. KI-Sprachmodelle, auch Large Language Models (LLMs) genannt, sind Computerprogramme, die in der Lage sind, natürliche Sprache in geschriebener Form automatisiert zu verarbeiten. Der Name ChatGPT ist eigentlich eine Abkürzung und steht für

| Chat | Textbasierte Unterhaltungen |

| Generative | Texte werden selbtständig erzeugt |

| Pre-trained | Vor-trainiert auf eine grosse Anzahl von Textdaten |

| Transformer | Neuronales Netzwerkmodell, welches langen zusammenhängenden Text erfassen kann. |

Was kann ChatGPT?

Folgende Dinge können KI-Sprachmodelle ausserordentlich gut erledigen:

ChatGPT ist nur ein Vertreter der LLMs. Gratis nutzbar ist es in der Version GPT-3.5, kostenpflichtig in der Version 4 und die Version 5 ist auch schon angekündigt worden.

Was ist der Unterschied zur kostenpflichtigen Version?

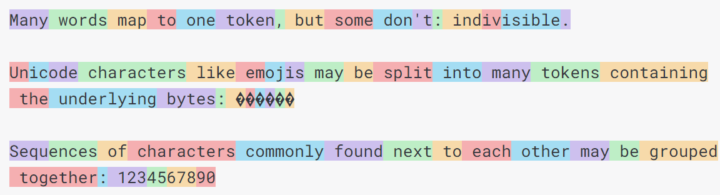

Da muss ich noch ein bisschen ausholen: ChatGPT arbeitet mit Tokens. Lapidar gesagt ist es vergleichbar mit der Aufmerksamkeitsspanne. Je mehr Tokens vorhanden sind, desto mehr kann sich ChatGPT merken und zusammenhängend ausgeben. Die GPT-Version 3.5 arbeitet mit 4096 Tokens für die Ein- und Ausgabe. D.h. je länger die Eingabe ist, desto kürzer wird die Ausgabe sein, da nach 4096 Tokens Schluss ist.

Ein Token kann ein Buchstabe, eine Interpunktion oder eine Teilsequenz eines Wortes sein. 100 Tokens sind im Englischen ca. 75 Wörter.

D.h. die neueren GPT-4- und GPT-5- bzw. kostenpflichtigen Versionen können mehr Tokens verarbeiten und basieren auch auf einer grösseren und aktuelleren Datenbasis. Mit der Browsing-Funktion ist es sogar möglich, im Internet auf aktuelle Inhalte zuzugreifen und diese zu verwenden.

Microsoft hat ja bekanntlich zehn Milliarden in OpenAI investiert und darf deshalb GPT-4 im Bing-Chat verwenden. Leider ist die Qualität und Geschwindigkeit aus meiner Sicht nicht so gut wie das originale ChatGPT.

Beispiele

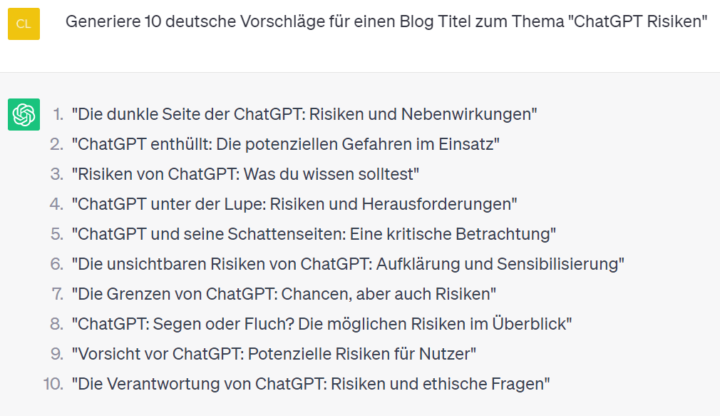

Ich gebe es zu: Ich bin ein leidenschaftlicher ChatGPT-Nutzer. Vor allem was die rasche Generierung von Texten und E-Mails anbelangt, aber auch als Ideen-Tool finde es ich ausserordentlich nützlich.

KI in der Security-Branche

Der grosse Nutzen der KI wurde schon früh von der IT-Security-Branche erkannt und es wurde viel investiert, um die riesigen Datenmengen sinnvoll zu verarbeiten. Zscaler zum Beispiel (PDF) hat schon seit 2018 KI-Technologien im Einsatz. Check Point wiederum nutzt über 40 KI Systeme, um seine Lösungen noch sicherer zu machen und so die User besser zu schützen. Vectra setzt voll und ganz auf KI (PDF), damit die vielen NDR-Events runtergebrochen werden auf die wichtigsten Alarme.

Ich denke, KI ist nahezu ein Standard geworden für fast alle Hersteller und wir werden noch mehr in Zukunft davon profitieren. Aber nun zum eigentlichen Thema:

ChatGPT-Risiken

Wie bei jeder neuen Technologie bietet sie immense Vorteile, doch im Laufe der Zeit zeigen sich auch Risiken. Aus meiner Sicht sind die folgenden Risiken erwähnenswert:

- Erstellung von Spam- und Phishing-Mails

Da ChatGPT in der Lage ist, menschenähnlichen Text zu generieren, könnten Kriminelle versuchen, diese Technologie für betrügerische Zwecke einzusetzen. Spam-Mails könnten verwendet werden, um unerwünschte Werbung oder betrügerische Inhalte zu verbreiten. Das Erstellen von fehlerfreien Phishing-Mails mit einem kopierten Schreibstil könnte so kaum mehr erkannt werden. Xorlab hat dazu einen lesenswerten Blogartikel geschrieben. - Erstellen und Verbesserung von Schadsoftware

Kriminelle könnten versuchen, ChatGPT einzusetzen, um bösartige Programme und Malware zu entwickeln. Dies könnte dazu führen, dass die Schadsoftware effektiver und neue Wege finden würde, um Sicherheitsmechanismen zu umgehen. Check Point Research hat dazu einen interessanten Blogartikel geschrieben. - Echtzeit-Chats

In Fällen erfolgreicher Phishing-Angriffe landet das Opfer auf einer betrügerischen Website, auf welcher der Angreifer mithilfe von Echtzeit-Chats das Opfer gezielt in die Irre führen könnte. Durch geschickte Manipulation könnte der Angreifer versuchen, das Opfer dazu zu bringen, persönliche Zugangsdaten preiszugeben. Diese gefährliche Taktik würde es Kriminellen ermöglichen, sensible Informationen wie Passwörter oder Kreditkartennummern zu erlangen. - Data Leaks

ChatGPT ist ein Software-as-a-Service (SaaS) und man muss sich mit einer gültigen E-Mails-Adresse registrieren und ein Passwort setzen. Jetzt kann man sich natürlich fragen: Ein Cloud Service, für den man nichts bezahlt und es wird ja auch keine Werbung geschaltet – womit verdient denn OpenAI sein Geld?

Vermutlich zielt OpenAI darauf ab, die Akzeptanz von ChatGPT zu steigern und Nutzer abhängig zu machen. Auch wird sein Dienst durch die Nutzung der Menschen immer besser und OpenAI kann dann von Drittfirmen wie z.B. Microsoft mehr Geld für seine Lösung verlangen.

Generell gilt immer: Wenn man für etwas nichts bezahlt, dann zahlt man mit seinen Daten.

Es ist aus meiner Sicht sehr wichtig, bei der Nutzung von ChatGPT keine Namen, Kundendaten, datenschutzrelevante oder geheime Unternehmensinformationen, wie zum Beispiel Code oder Umsatzzahlen, zu verwenden, da man nicht genau weiss, wer darauf Zugriff hat oder haben wird. Kürzlich tauchten über 100’000 ChatGPT Logins im Darkweb auf.

Mein Tipp: Jetzt wäre es an der Zeit, seine «History» zu löschen.

Ein weiterer bekannt gewordener Vorfall ereignete sich bei einem Samsung-Mitarbeitenden, der ChatGPT zur Code-Optimierung genutzt hat und so unabsichtlich sensitiven Code veröffentlicht hat.

Fake News / Automatisierte Bewertungen

ChatGPT könnte auch zur Verbreitung von Fake News, Propaganda und Hassnachrichten verwendet werden. Kriminelle oder bösartige Akteure könnten die Technologie nutzen, um manipulative Inhalte zu erstellen, die Desinformation verbreiten oder Hass schüren würden.

Darüber hinaus bestünde die Möglichkeit, dass ChatGPT für automatisierte Bewertungen von Produkten oder Dienstleistungen eingesetzt werden würde. Dies könnte dazu führen, dass gefälschte oder manipulierte Bewertungen erstellt würden, um den Ruf eines Produkts zu verbessern oder die Konkurrenz zu schädigen.

Auch ist ein bekanntes Problem von ChatGPT, dass, wenn es etwas nicht genau «weiss», trotzdem etwas behauptet wird, natürlich ohne Quellenangaben. Dieser Vorgang wird auch als «Halluzinieren» bezeichnet. Im Tagesanzeiger ist dazu ein guter Artikel erschienen.

Es ist in Zukunft ratsam, stets eine kritische Haltung einzunehmen und Informationen aus verschiedenen Quellen zu prüfen.

Was kann man dagegen tun?

Die erste Reaktion ist es, ChatGPT bei so vielen Risiken komplett zu sperren (z.B. mit der Fortinet-Methode). Was aus meiner Sicht nicht viel bringt, da es unterdessen hunderte ähnlicher KI-Dienste gibt. Auch ist es immer möglich, private Geräte zu verwenden und so hat man als Unternehmen eigentlich nichts gewonnen. Die Mitarbeitenden sind allgemein für ihre Kreativität bekannt.

Eine weitere Möglichkeit ist die Sensibilisierung der User mittels Coaching-Seiten (z.B. mittels der Zscaler-Methode). Ich denke, es ist auf jeden Fall wichtig, die Mitarbeitenden aufzuklären, was passieren könnte und welches die Risiken sind.

Mein Fazit zu ChatGPT-Risiken

Ja, es gibt Risiken, aber diese kann man kaum ausschliesslich mit technischen Mitteln in den Griff kriegen. Es wäre besser, jetzt schon die Mitarbeitenden einzubeziehen, da Microsoft in der nächsten Windows-Version seinen Microsoft-365-«Co-Piloten» flächendeckend integrieren wird.

Die Zukunft ist AI!

Beispiel: Microsoft integriert bereits ChatGPT in Microsoft 365

Weitere Informationen

Lavar

Lavar ist Security-Spezialist und langjähriger Mitarbeiter bei AVANTEC. Am liebsten beschäftigt er sich mit Firewalls, E-Mail Gateways, Proxy-, Cloud-Lösungen und Linux. Lavar interessiert sich vor allem für technische Details.